Une seconde ajoutée parce que la Terre tourne moins vite

Sans que nous en rendions compte, la Terre tourne de plus en plus lentement… Pas que quoi s’affoler toutefois. Pour rattraper le minuscule retard sur le jour solaire théorique de 24 heures, les horloges vont ajouter une seconde, ce soir, samedi 30 juin 2012. A 23:59:59, il sera donc 23:59:60 ou 00:00 dimanche 1er juillet. Contrairement aux horaires d’été et d’hivers, cela ne va pas bousculer notre emploi du temps ni notre rythme biologique. Mais cela révèle un phénomène très ancien qui fait partie de la vie de notre planète. Ainsi, du temps des dinosaures, le jour durait 23 heures au lieu de 24 heures. Mais c’était il y a au moins 65 millions d’années…

Sans que nous en rendions compte, la Terre tourne de plus en plus lentement… Pas que quoi s’affoler toutefois. Pour rattraper le minuscule retard sur le jour solaire théorique de 24 heures, les horloges vont ajouter une seconde, ce soir, samedi 30 juin 2012. A 23:59:59, il sera donc 23:59:60 ou 00:00 dimanche 1er juillet. Contrairement aux horaires d’été et d’hivers, cela ne va pas bousculer notre emploi du temps ni notre rythme biologique. Mais cela révèle un phénomène très ancien qui fait partie de la vie de notre planète. Ainsi, du temps des dinosaures, le jour durait 23 heures au lieu de 24 heures. Mais c’était il y a au moins 65 millions d’années…

La définition de la seconde se passe de la Terre

En fait, c’est en 1820 que la Terre effectuait une rotation complète en exactement 24 heures, soit 86 400 secondes. Depuis, son ralentissement s’est poursuivi et “le jour solaire s’est accru d’environ 2,5 millisecondes”, indique Daniel MacMillan du Goddard Space Flight Center de la NASA. Le phénomène n’était pas perceptible lorsque la définition de la seconde s’appuyait sur la durée d’un jour solaire. Mais en 1967, les scientifiques ont modifié cette définition en se fondant, désormais, sur les transitions électromagnétiques dans les atomes de césium. Les horloges atomiques étaient nées. Elles disposent d’une précision d’une seconde sur 1,4 million d’années et déterminent le temps universel coordonné (UTC) déconnecté de la rotation de la Terre.

Des références situées à plusieurs milliards d’années lumière

Aujourd’hui, les scientifiques calculent la durée exacte d’une rotation de la Terre sur elle-même grâce à la technique VLBI (Very Long Baseline Interferometry) qui est exploitée à l’aide de multiples stations réparties sur le planète. Toutes pointent sur des objets célestes tels que des quasars situés extrêmement loin (plusieurs milliards d’années lumière) et, donc, pratiquement immobiles lorsqu’ils sont observés depuis la Terre. Le laboratoire Goddard de la Nasa se charge de la coordination de ces mesures et de leur traitement. C’est grâce à cette technique qu’il est possible de mesurer le ralentissement de la rotation de notre planète dû à la force de marée entre la Terre et la Lune.

25 minutes de retard dans 500 ans

Il va de soi que ce ajout d’une seconde n’est critique que pour des instruments ayant besoin d’une extrême précision dans la mesure du temps. Certains estiment que le coût de l’arrêt de tels systèmes qui permet d’ajouter la seconde en question n’est pas justifié et ils plaident pour laisser les horloges dériver au fil de ces infimes différences. Aucune décision dans ce domaine ne devrait être prise avant 2015. L’enjeu n’est pas tout à fait négligeable. Sans les corrections comme celle qui a lieu aujourd’hui, la dérive atteindrait tout de même 25 minutes dans 500 ans. Le saut de seconde du 30 juin 2012 est le 35ème à être réalisé et le premier depuis 2008.

Michel Alberganti

lire le billetImage: Les feux de forêt près de Colorado Spring

Le feu de forêt «Waldo Canyon Fire» a détruit près de 350 maisons en une semaine, depuis le 23 juin 2012, et provoqué l’évacuation de 36 000 personnes. Le satellite Pléiades 1A d’Astrium, lancé en décembre 2011, réalise des images avec une résolution de 50 cm. Retravaillée par les géo-experts d’Astrium, l’image ci-dessus permet d’étudier les zones protégées par des produits retardants, en particulier à proximité des habitations.

Cliquez sur l’image pour l’agrandir

Et regardez les photos des incendies sur le Grand Format de Slate.fr

Michel Alberganti

lire le billet

Facebook renforcerait l’estime de soi et MySpace le narcissisme

Le nombre d’utilisateurs actifs de Facebook est passé de 1 million fin 2004 à 900 millions en mars 2012. A la même date, dans le classement des sites les plus visités, Facebook se place en deuxième position derrière Google et devant Youtube. Twitter est huitième, Linkedin douzième. C’est dire l’importance prise par les réseaux sociaux sur Internet. D’où vient un tel succès ? Des chercheurs de l’université de Géorgie, à Athens aux Etats-Unis, se sont penchés sur cette question en essayant de comprendre ce que tant d’internautes “aiment” (like) dans ces réseaux sociaux. La réponse est simple: eux-mêmes…

“En dépit de la dénomination “réseaux sociaux”, la plus grande partie de l’activité des utilisateurs de ces sites est centrée sur eux-mêmes”, note Brittany Gentile, une doctorante qui s’est intéressée à l’impact des réseaux sociaux sur l’estime de soi et le narcissisme dans une étude publiée le 5 juin 2012 dans la revue Computers in Human Behavior. Ainsi, les 526 millions de personnes qui se connectent à Facebook tous les jours pourraient bien rechercher davantage à renforcer leur estime d’eux-mêmes qu’à se faire de nouveaux “amis”. Pour Keith Campbell, professeur de psychologie à l’université de Géorgie et co-auteur de l’article, “il semble que l’utilisation, même pendant un court moment, de ces réseaux sociaux aient un effet sur la façon dont les utilisateurs se voient eux-mêmes. Soit en s’éditant, soit en se construisant. Dans les deux cas, les utilisateurs se sentent mieux avec eux-mêmes mais le premier renvoie au narcissisme et le second à l’estime de soi”.

Pour aboutir à ces conclusions, les chercheurs ont réalisé des expériences avec des étudiants utilisateurs de MySpace (classé 62ème site) et de Facebook. Dans les deux cas, les participants ayant le plus niveau de narcissisme le plus élevé étaient ceux qui déclaraient le plus grand nombre d’amis. Un groupe de 151 étudiants âgés de 18 à 22 ans ont rempli le formulaire d’évaluation du narcissisme qui faisait partie de l’étude. “Le narcissisme est un trait de personnalité stable, indique Brittany Gentile. Pourtant, après 15 minutes passées sur l’édition d’une page de MySpace et sur l’écriture de ce qu’elle signifie, l’auto-évaluation du trait narcissique s’est révélé modifiée. Cela suggère que les sites de networking social peuvent avoir une influence significative sur le développement de la personnalité et de l’identité”.

Pour aboutir à ces conclusions, les chercheurs ont réalisé des expériences avec des étudiants utilisateurs de MySpace (classé 62ème site) et de Facebook. Dans les deux cas, les participants ayant le plus niveau de narcissisme le plus élevé étaient ceux qui déclaraient le plus grand nombre d’amis. Un groupe de 151 étudiants âgés de 18 à 22 ans ont rempli le formulaire d’évaluation du narcissisme qui faisait partie de l’étude. “Le narcissisme est un trait de personnalité stable, indique Brittany Gentile. Pourtant, après 15 minutes passées sur l’édition d’une page de MySpace et sur l’écriture de ce qu’elle signifie, l’auto-évaluation du trait narcissique s’est révélé modifiée. Cela suggère que les sites de networking social peuvent avoir une influence significative sur le développement de la personnalité et de l’identité”.

Des différences entre les pages des deux sites

Plus étonnant encore, les chercheurs ont noté des différences d’impact qui semblent liées, au moins en partie, au format et au type des pages éditées sur les deux sites. Ainsi, MySpace augmenterait le narcissisme alors que Facebook renforcerait l’estime de soi. Brittany Gentile souligne ainsi des différences dans le fonctionnement des deux réseaux sociaux. “Sur MySpace, vous n’interagissez pas vraiment avec les autres et les pages du site ressemblent à des pages personnelles. Ces dernières ont permis à une grand nombre de personnes de devenir célèbres. En revanche, Facebook propose des pages standardisées et le message de l’entreprise est que “le partage rendra le monde meilleur””.

Depuis les années 1980

D’autres études ont constaté une croissance, au fil des dernières générations, à la fois de l’estime de soi et du narcissisme. Les travaux des chercheurs de l’université de Géorgie suggèrent que la popularité croissante des réseaux sociaux peut jouer un rôle dans ces tendances. Néanmoins, les auteurs soulignent que le phénomène est observé depuis les années 1980, bien avant la création de Facebook en 2004. Keith Campbell estime que les réseaux sociaux sont à la fois un produit d’une société de plus en plus absorbée par elle-même, et la cause d’un renforcement des traits de personnalité correspondants. “Dans l’idéal, l’estime de soi nait lorsque l’on a de fortes relations et que l’on atteint des objectifs raisonnables pour l’âge que l’on a. Dans l’idéal, l’estime de soi ne peut pas être atteinte par un raccourci. C’est la conséquence d’une vie réussie, pas quelque chose que l’on peut poursuivre”, note-t-il sagement.

Réseaux égocentriques

Moralité : Les réseaux sociaux semblent avoir plus d’influence sur l’égo de leurs utilisateurs que sur leurs aptitudes relationnelles. Ils conduisent, au mieux, à fabriquer une estime de soi artificielle, plus fondée sur l’apparence que sur la réalité. Au pire, ils développent un fort égo-centrisme en contradiction avec la vocation “sociale” de ces réseaux. Notons, toutefois, que l’architecture du site, tout comme le slogan de l’entreprise qui l’a créé, peuvent influencer fortement ses impacts sur la personnalité des utilisateurs. A choisir, mieux vaut quand même une amélioration de l’estime de soi, même artificielle, qu’une plongée dans le narcissisme exacerbé, non ?

Michel Alberganti

lire le billetLes particules diesel flashées par un laser

Comme les milliards de particules qui peuplent l’air que nous respirons, surtout en ville, les suies émises par les moteurs diesel font particulièrement débat depuis que l’Organisation mondiale de la santé (OMS) les a classées comme cancérogènes certains pour l’homme (lire l’article de Gilles Bridier à ce sujet). L’une des difficultés pour appréhender ce type de pollution atmosphérique réside dans son caractère invisible et souvent inodore. Or, on le sait bien, ce que l’on ne voit pas est moins inquiétant que ce que l’on voit. Pourtant, ces particules, dangereuses pour la santé, jouent également un rôle dans le changement climatique. D’où l’intérêt de pouvoir mieux les observer. C’est justement le but des travaux publiés par le Centre pour le laser à électrons libres (CFEL) de Hambourg dans la revue Nature de cette semaine.

Laser à rayon X

“Pour la première fois, nous pouvons réellement voir la structure de particules individuelles flottant dans l’air, leur habitat naturel”, déclare Henry Chapman, un chercheur de l’Électron-synchrotron allemand (DESY), membre du CFEL. Pour y parvenir, les scientifiques ont dû trouver un moyen plus efficace que la lumière visible ou les rayons X. Finalement, la solution a été apporté par le plus puissant laser à rayon X actuel, le LCLS, issu de l’accélérateur SLAC fondé par le ministère de l’énergie américain (DOE) à Stanford. De tels lasers utilisent les électrons libres, c’est à dire non liés à un atome, produits par un accélérateur de particules. Au LCLS, ces électrons émettent ensuite des photons ayant la longueur d’onde des rayons X. A Hambourg, un système similaire est en cours de construction, le XFEL, qui doit entrer en service en 2015. Il existe également un projet de ce type en France en collaboration avec le Synchrotron Soleil.

Particules de moins de 2,5 microns

La partie dans laquelle les électrons ondulent mesure de 3 à 4 km, ce qui fait du laser à électrons libres un instrument qui n’est pas vraiment portatif… Néanmoins, les chercheurs du CFEL sont parvenus à une première sur les particules de moins de 2,5 microns (millièmes de mm) qui correspondent à celles qui pénètrent dans nos poumons et qui arrivent en seconde position, après le CO2, parmi les acteurs du réchauffement climatique. Pour l’expérience, les chercheurs ont fabriqué eux-mêmes des particules de suie à partir d’un morceau de graphite et ils les ont dispersées, mélangées à du sel, dans un flux d’air. C’est cet aérosol qui a été intercepté par le rayon laser à électrons libres. L’interaction entre les pulsations du laser et les particules ont produit une diffraction de la lumière que les scientifiques ont enregistrée. A partir de ces motifs de diffraction, ils sont capables de reconstituer la structure de la particule qui les a engendrés.

“La structure des particules détermine comment elle disperse la lumière”, explique Andrew Martin, un autre signataire de l’étude travaillant au DESY. “Et ce phénomène explique comment l’énergie solaire est absorbée par l’atmosphère terrestre et joue ainsi un rôle majeur dans les modèles climatiques. De même, il existe de nombreux liens entre ces particules d’environ 2 microns et les effets négatifs sur la santé”, note le chercheur. Grâce au laser à électrons libres, la forme et la composition de particules individuelles ont pu être analysées. Cela pourrait permettre de mieux comprendre comment elles interfèrent avec les fonctions des cellules dans les poumons.

Dimension fractale importante

L’équipe du CFEL a ainsi analysé 174 particules dont elle a également mesuré la compacité en utilisant une propriété appelée “dimension fractale” et qui décrit comment un objet rempli l’espace. Les chercheurs ont été surpris par les valeurs obtenues, supérieures à ce qu’ils attendaient. La preuve d’une compacité importante. De même, la structure des particules s’est révélée étonnamment variable ce qui révèle un nombre important de déformations dans l’air.

Réchauffement climatique et suies de moteurs diesel

Ces travaux laissent entrevoir la possibilité de mieux visualiser l’évolution de la formation des suies dans un moteur diesel, par exemple, et même d’analyser les premières étapes de la formation des cristaux de glace dans les nuages. Ils pourraient affiner les modèles climatiques qui en ont besoin en matière d’interaction entre l’énergie solaire et l’atmosphère terrestre. Pour les constructeurs automobiles, de précieuses informations sur les fameuses suies émises par les moteurs diesel pourraient permettre d’en réduire la quantité ou d’en atténuer la dangerosité pour la santé humaine.

Michel Alberganti

lire le billetLonesome George : la fin de la solitude

Une ligne de plus sur la liste du dodo et de la rhytine de Steller, une encoche de plus pour marquer l’empreinte humaine sur la biodiversité.

Dimanche dernier, très précisément, l’espèce de tortues géantes des Galapagos Chelonoidis abingdonii s’est éteinte avec son ultime représentant.

L’impressionnant Lonesome George était centenaire et méritait bien son surnom de « Georges le solitaire » : il vivait en captivité depuis une quarantaine d’années, sans camarade de son espèce car son île (Pinta) avait vu son l’écosystème bouleversé par l’introduction de chèvres par l’homme.

Malgré un enthousiasme assez limité pour le jeu de la bête à deux carapaces, Lonesome George a prêté sa participation à de nombreuses tentatives de reproduction avec des femelles de sous-espèces proches, et après des années d’échec la fortune a semblé enfin lui sourire avec des œufs hybrides pondus en 2008. Mais l’espoir fut de courte durée, et aucun de ces œufs n’a éclos.

Son autopsie a conclu à une mort naturelle, et son imposante dépouille va être confiée à un taxidermiste, et continuera à attirer les touristes.

Le temps est révolu où le dernier représentant d’une espèce de vertébrés pouvait être abattu des années avant qu’on en comprenne la portée, comme ce fut le cas pour le zèbre quagga ou le loup de Tasmanie. La prise de conscience de la fin de l’espèce a ici largement précédé le décès de son dernier représentant, et en quelques heures, la nouvelle de la mort de Lonesome George a fait le tour de la planète.

C’est sans doute une bonne nouvelle en terme de sensibilisation à la biodiversité (et pas seulement celle des grands vertébrés charismatiques), mais il est difficile de ne pas rester songeur devant cette rencontre de l’instantanéité des nouvelles avec les échelles de temps immenses qui accompagnent l’évolution et la disparition irrévocable d’une espèce.

Fabienne Gallaire

Lire aussi :

- Lonesome George, la dernière tortue géante, est morte, sur Slate.fr.

- Lessons From the Death of Lonesome George, the World’s Last Pinta Island Tortoise, sur Slate.com.

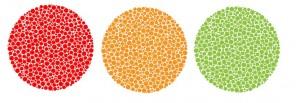

Au-delà de l’arc-en-ciel : quatre cônes et des millions de couleurs

L’histoire de la physiologie est formelle, on apprend beaucoup des erreurs : la compréhension du fonctionnement du corps humain doit énormément à l’étude des problèmes, anomalies, accidents ou pathologies qui permettent de décomposer le ballet si complexe de notre petit intérieur.

La vision des couleurs, par exemple, a commencé à être comprise grâce aux travaux de John Dalton au XVIIIe siècle, qui diagnostiqua son propre daltonisme. On sait aujourd’hui que la vision humaine des couleurs est due à des cellules spécialisées de la rétine : les cônes, dont nous avons trois types, que l’on classe en fonction de la couleur qu’ils captent. Selon que la longueur d’onde la mieux perçue est courte, moyenne ou longue, on les appellera S (short, captant le bleu), M (medium, le vert) et L (long, le rouge).

Quand l’un de ces trois récepteurs ne fonctionnent pas, c’est la dyschromatopsie (nom médical du daltonisme). Le cône touché L, M ou S (protanopie, deutéranopie ou tritanopie), correspond à un problème avec le gène qui produit ce récepteur. Dans les deux premiers cas, la déficience génétique est portée par le chromosome X, ce qui explique la transmission assez particulière du défaut. Les femmes sont en général dépourvues de symptômes et ont une chance sur deux de transmettre la version mutée du gène d’un récepteur à leurs enfants. En l’absence de deuxième chromosome X non-muté, les fils n’auront alors que deux cônes fonctionnels sur trois.

Et les filles, alors ? Au premier coup d’œil, elles n’ont rien de particulier : après tout, n’ont-elles pas une version normale du gène pour produire le cône ? C’est vrai pour la plupart d’entre elles, mais leur cas continuait à exciter la curiosité des chercheurs. En effet, la mutation peut entraîner la fabrication d’un cône certes anormal, mais fonctionnel, c’est-à-dire sensible à certaines longueurs d’onde, mais pas les « bonnes ».

Voici longtemps que des scientifiques, comme la chercheuse Gabriele Jordan de Cambridge, s’interrogent : ce qui pose un problème quand on n’a que cela à disposition (daltonien) ne pourrait-il pas apporter une sensibilité supplémentaire à des couleurs insoupçonnées ?

Cette question est autrement plus difficile que le diagnostic de daltoniens par des médecins à la vue normale, qui n’ont eux-mêmes pas de problème avec les tests d’Ishihara. Comment évaluer une capacité sensorielle quand on ne la possède pas soi-même ?

Des études avaient déjà détecté des porteuses de quatre cônes différents, mais le signal nerveux était traité comme s’il n’y en avait que trois : pas de super-pouvoir… Comment Jordan a-t-elle tenté de dénicher la toute première tétrachromate au monde ? Elle a couplé une approche purement sensorielle à des analyse moléculaires.

Pour tenter de détecter ces insaisissables mutantes, la chercheuse a conçu un exercice qui demande de mélanger deux types de lumière pour former une couleur donnée. Avec une vision banalement trichromate, plusieurs combinaisons différentes produiront une sensation colorée identique, sans que les sujets puissent faire la différence. La plupart des gens sont incapables de différencier un violet monochromatique (une seule longueur d’onde) de la couleur obtenue en mélangeant du bleu et du rouge.

Chez un tétrachromate au contraire, le nombre de combinaisons perçues de la même façon sera très réduit. Parmi les quatorze femmes qui ont passé ce test, toutes mères de fils daltoniens, une seule, dont le nom de code est cDa29, a obtenu les résultats attendus et l’analyse génétique a montré qu’elle avait bien trois cônes distincts dans les hautes fréquences, là où une personne normale n’a que le M et le L. D’après son entourage, elle avait déjà démontré sa finesse d’observation pour les couleurs, mais personne ne se doutait qu’elle pouvait voir des couleurs normalement invisibles.

Si vous êtes une femme et que vous avez des daltoniens dans votre famille, il y a donc une (faible) probabilité que vous soyez tétrachromate. En fonction de la mutation qui affecte votre cône surnuméraire, votre perception peut être finalement assez proche de celle des trichromates, ou, plus exceptionnellement encore, offrir vraiment une dimension colorée supplémentaire à votre espace chromatique, comme pour cDa29. Mais si par extraordinaire c’était le cas, ne vous étonnez pas d’avoir du mal à vous faire comprendre quand vous parlez décoration…

Ces différences de perception vous plongent peut-être dans des abîmes métaphysiques, mais consolez-vous. Chez la plupart des singes du Nouveau monde, elles sont encore plus brutales : les femelles ont en général trois types de cônes alors que les mâles n’en ont que deux. Les pauvres ? Pas forcément. Si les premières perçoivent mieux les couleurs, les seconds sont plus à même de détecter les fruits camouflés en feuilles, ce qui ne peut que bénéficier à la cueillette faite en commun.

Pour conclure, chers lecteurs trichromates, si cet article a déçu vos espoirs, ne reposez pas tout de suite votre costume de super-héros ! Qui sait, peut-être êtes-vous un super-goûteur ?

Fabienne Gallaire

Références :

- The dimensionality of color vision in carriers of anomalous trichromacy, Gabriele Jordan, Samir S. Deeb, Jenny M. Bosten, J. D. Mollon, Journal of Vision, 1er juillet 2010, 1;10(8):12.

- The Humans With Super Human Vision, Veronique Greenwood, Discover Magazine, 18 juin 2012.

- Detecting tetrachromacy in human subjects, Jakab Z, Wenzel K, Perception, 33, 2004.

lire le billet

D’ici 5 ans, des photos gigapixels

Ceux qui ont vécu la progression des capteurs électroniques utilisés dans les appareils photo numériques (APN) et les caméscopes ne connaissent désormais plus qu’une unité: le mégapixel. Qui se souvient encore du Mavica lancé par Sony, le tout premier APN avec ses 280 000 pixels ? Ou du Xapshot de Canon (1989) ? Ou encore du QuickTake d’Apple (1994) et ses 300 000 pixels ? Il faut attendre 1999 pour que les professionnels puissent acquérir un APN dépassant le million de pixels, le Nikon D1 avec 2,7 mégapixels. Les années 2000 seront celles de la course aux mégapixels avec des résultats mitigés, tant le nombre de pixels ne doit pas faire oublié leur qualité. Or, plus les pixels sont petits, moins ils captent de lumière. Des millions de pixels sur un capteur minuscule donne ainsi des résultats inférieurs à un nombre de pixels inférieur sur un grand capteur. D’où la nouvelle course, engagée depuis quelques années, celle de la taille des capteurs avec, comme objectif, le fameux format 24×36 mm de la bonne vieille pellicule argentique. Se profile aujourd’hui, la perspective de la généralisation d’appareils munis d’un tel capteur, dit “plein format”, dotés de 30 à 40 mégapixels contre moins de 20 aujourd’hui à de rares exceptions comme le récent Nikon D800 avec ses 36,3 mégapixels vendu à près de 3000 euros nu.

Tout cela pour préciser le contexte dans lequel arrive la publication, dans la revue Nature du 20 juin 2012, d’un article publié par des ingénieurs de l’université Duke et de l’université d’Arizona. En synchronisant 98 micro appareils photo, ils sont parvenus à obtenir des images de 50 gigapixels, soit 50 0000 mégapixels… Avec une définition 1000 fois supérieure à celle des meilleurs appareils actuels, les chercheurs multiplient par 5 la résolution des meilleurs yeux humains. Cela sur un champ de vision de 120° (contre 220° pour l”homme).

David Brady, qui dirige l’équipe, explique que “chacune des micro appareils photo capture les informations provenant d’une partie de la scène tandis qu’un ordinateur réalise la fusion de ces images en une seule image de très haute définition. Dans ce nombreux cas, l’appareil peut capter des détails que le photographe ne voit pas à l’œil nu et qu’il découvre ensuite en regardant l’image”. D’après lui, même s’il faudra développer des optiques spéciales, le problème principal viendra de la maîtrise de la consommation électrique et de la miniaturisation des circuits électroniques.

Le logiciel d’assemblage des différentes images a été réalisé par Michael Gehm, professeur assistant d’électricité et d’informatique à l’université d’Arizona. “Notre approche actuelle, au lieu de créer des optiques de plus en plus complexes, est d’utiliser des réseaux d’éléments électroniques massivement parallèles. Un objectif partagé capte la lumière et la répartit sur les micro caméras, exactement comme une réseau informatique gère les données destinées à différentes stations de travail. Chacune de ces dernières ne voit qu’une petite partie du problème à traiter . Pour l’image, nous prévoyons des parties de recouvrement qui permettent de ne pas perdre d’information”, indique-t-il.

Le logiciel d’assemblage des différentes images a été réalisé par Michael Gehm, professeur assistant d’électricité et d’informatique à l’université d’Arizona. “Notre approche actuelle, au lieu de créer des optiques de plus en plus complexes, est d’utiliser des réseaux d’éléments électroniques massivement parallèles. Un objectif partagé capte la lumière et la répartit sur les micro caméras, exactement comme une réseau informatique gère les données destinées à différentes stations de travail. Chacune de ces dernières ne voit qu’une petite partie du problème à traiter . Pour l’image, nous prévoyons des parties de recouvrement qui permettent de ne pas perdre d’information”, indique-t-il.

L’appareil prototype mesure 50 cm de profondeur dont 3% seulement sont affectés à l’optique. Le reste est occupé par l’électronique qui se charge d’assembler les différentes parties de l’image. David Brady précise que la taille actuelle est liée à celle des cartes électroniques de contrôle et à la nécessité de les refroidir. “Lorsque des composants électroniques plus compacts et plus efficaces seront disponibles, l’ère de la photographie gigapixel s’ouvrira”, affirme-t-il. Les chercheurs estiment ainsi que, d’ici 5 ans, la miniaturisation des composants électroniques permettra de proposer des appareils photos gigapixel au grand public.

Michel Alberganti

lire le billetUne micro batterie sous le crâne alimentée par le cerveau

L’un des derniers freins au développement de l’homme bionique réside, à l’évidence, dans l’épineuse question de l’alimentation électrique des implants électroniques, en particulier lorsqu’ils sont situés dans le cerveau. Rien n’est plus disgracieux que des fils sortant du crâne ou des boitiers sans fil glissés sous le cuir chevelu. Au delà de l’aspect esthétique, qui a son importance lorsqu’on imagine un être humain augmenté, ces solutions requièrent un changement régulier des piles qui gâche un peu le rêve de tout Bioman qui se respecte. D’où l’intérêt des travaux d’une équipe du Massachusetts Institute of Technology (MIT) à Cambridge qui font l’objet d’une publication dans la revue PLoS one le 12 juin 2012.

L’un des derniers freins au développement de l’homme bionique réside, à l’évidence, dans l’épineuse question de l’alimentation électrique des implants électroniques, en particulier lorsqu’ils sont situés dans le cerveau. Rien n’est plus disgracieux que des fils sortant du crâne ou des boitiers sans fil glissés sous le cuir chevelu. Au delà de l’aspect esthétique, qui a son importance lorsqu’on imagine un être humain augmenté, ces solutions requièrent un changement régulier des piles qui gâche un peu le rêve de tout Bioman qui se respecte. D’où l’intérêt des travaux d’une équipe du Massachusetts Institute of Technology (MIT) à Cambridge qui font l’objet d’une publication dans la revue PLoS one le 12 juin 2012.

Carburant: le glucose du liquide cérébro-spinal

Rahul Sarpeshkar, informaticien, et ses collègues du MIT et de la Harvard Medical School, annoncent avoir conçu une technologie qui permet de collecter de l’énergie électrique directement dans le cerveau. Il ne s’agit de rien de moins que d’une pile à combustible utilisant comme carburant le glucose du liquide cérébro-spinal. La pile fonctionne en retirant des électrons du glucose, c’est à dire en les oxydant. Cela marche dans une solution saline simulant le liquide cérébro-spinal. Ne nous emballons donc pas… Les scientifiques ignorent, pour l’heure, l’impact de cette puce sur le cerveau lui-même.

Une puce électronique minuscule dans la tête

Car, en fait, il s’agit bien d’une batterie sur puce. De 1 à 2 millimètres carrés, le composant oxyde le glucose avec son anode en platine et convertit l’oxygène en eau à la surface d’un réseau de nanotubes de carbone intégré à la cathode. Les électrons arrachés au glucose fournissent de l’électricité. L’intérêt du système est qu’il peut fonctionner, en théorie, indéfiniment. Du moins, tant qu’il y a du glucose dans le liquide cérébro-spinal. La première crainte qui vient à l’esprit concerne les effets d’une telle exploitation d’un liquide du cerveau… sur le cerveau lui-même.

Pas de perturbation du cerveau

D’après leurs calculs, les chercheurs estiment que la pile consommerait entre 2,8% et 28% du glucose qui est réapprovisionné en permanence. En effet, le cerveau produit de 500 à 1200 millilitres de liquide cérébro-spinal par jour. Soit un renouvellement complet des 150 millilitres qu’il contient toutes les 6 heures. Nous voici donc avec une production permanente du carburant de notre pile à combustible. Les scientifiques ont étalement analysé la consommation d’oxygène de la pile et ils estiment qu’elle ne devrait pas déstabiliser les niveaux nécessaires au cerveau. Mais rien ne vaut un essai sur un vrai cerveau…

Des fractions de microwatts

Pas question, si l’absence d’effets nocifs est confirmée, d’allumer une lampe frontale ou d’alimenter des lunettes de réalité augmentée. Encore moins de se projeter dans un monde virtuel à la Matrix… L’électricité produite ne dépasse pas les micro-watts (3,4 microwatts par centimètre carré en moyenne avec des pointes possibles à 180 microwatts par centimètre carré). Etant donné la taille réduite de la puce, elle ne produira que des fractions de microwatts. Mais cela pourrait être suffisant pour alimenter des implants permettant, par exemple, à des personnes paralysées de commander des systèmes leur permettant de réactiver la mobilité de leurs membres ou des équipements externes. On se souvient des expériences spectaculaires de contrôle d’un bras robotique par la pensée.

Michel Alberganti

lire le billetL’obésité pèse lourd sur la biomasse de l’humanité adulte

Sur les plus de 7 milliards d’individus de la population mondiale, le poids des adultes atteindrait 287 millions de tonnes, selon les chercheurs de la London School of Hygiene and Tropical Medicine. Sur ce chiffre, le surpoids représenterait 15 millions de tonnes et l’obésité 3,5 millions de tonnes. L’étude publiée dans le journal BMC Public Health est motivée par le fait que les besoins en nourriture de la population humaine dépendent non seulement du nombre d’individus vivant sur Terre mais également de leur poids. Ainsi, alors que la masse corporelle moyenne est de 62 kg sur le globe, elle atteint 80,7 kg en Amérique du Nord. Cette région, qui compte 6% de la population mondiale représente 34% de la biomasse due à l’obésité. Avec 61% de la population mondiale, l’Asie, elle, ne contribue qu’à 13% de cette biomasse due à l’obésité.

Sur les plus de 7 milliards d’individus de la population mondiale, le poids des adultes atteindrait 287 millions de tonnes, selon les chercheurs de la London School of Hygiene and Tropical Medicine. Sur ce chiffre, le surpoids représenterait 15 millions de tonnes et l’obésité 3,5 millions de tonnes. L’étude publiée dans le journal BMC Public Health est motivée par le fait que les besoins en nourriture de la population humaine dépendent non seulement du nombre d’individus vivant sur Terre mais également de leur poids. Ainsi, alors que la masse corporelle moyenne est de 62 kg sur le globe, elle atteint 80,7 kg en Amérique du Nord. Cette région, qui compte 6% de la population mondiale représente 34% de la biomasse due à l’obésité. Avec 61% de la population mondiale, l’Asie, elle, ne contribue qu’à 13% de cette biomasse due à l’obésité.

935 millions d’habitants de plus

Si tous les pays avaient le même indice de masse corporelle (IMB) que celui des Etats-Unis, la biomasse humaine mondiale totale augmenterait de 58 millions de tonnes, soit l’équivalent de 935 millions d’habitants ayant une masse corporelle moyenne. “Nos résultats mettent l’accent sur l’importance de considérer la biomasse et non seulement la population mondiale lorsque l’on étudie l’impact écologique d’une espèce, en particulier celle des hommes“, note Sarah Walpole, l’une des auteures de l’étude. Son collègue Ian Roberts ajoute que “tout le monde reconnaît que la croissance de la population humaine menace l’équilibre écologique mondial et notre étude montre que l’embonpoint est également un problème majeur. A moins de traiter les deux questions, nos chances sont minces”.

L’étude des chercheurs de la London School of Hygiene and Tropical Medicine est basée sur des chiffres des Nations Unies et de la World Health Organization (WHO) datant de 2005. Ce qui introduit une sous-estimation de la masse mondiale du fait de l’augmentation de l’obésité au cours des dernières années. Les Nations Unies indiquent que la population mondiale atteindra 8,9 milliards de personnes en 2050.

Un corps lourd consomme plus d’énergie

Les chercheurs soulignent que l’activité physique brule la moitié de l’énergie fournie par la nourriture ingérée. La croissance de la masse corporelle induit une augmentation des besoins énergétiques car la mise en mouvement d’un corps plus lourd requiert plus d’énergie. Même au repos, un corps plus lourd consomme plus.

Il apparaît ainsi que l’obésité n’est pas seulement un problème de santé publique. Elle a également un impact direct sur les besoin de l’humanité en termes de ressources agricoles, entre autres. Le développement des pays émergents comme la Chine et l’Inde risque fort d’aggraver encore la situation créée en grande partie par les États-Unis. A moins que la raréfaction de la nourriture n’apporte une solution naturelle au phénomène. La question est de savoir si cela fera maigrir la population des pays riches ou mourir de faim celle des pays pauvres.

Michel Alberganti

lire le billetDes moustiques OGM “malaria free”

Le moustique Anopheles (Cellia) stephensi a été génétiquement modifié pour tuer le parasite de la malaria

Les moustiques sont responsables de 300 à 400 millions de cas de malaria (ou paludisme) et de la mort d’un million de personnes par an dans le monde, principalement des nouveaux-nés, de jeunes enfants et des femmes enceintes. D’où l’intérêt des travaux menés par Anthony James et ses collègues de l’université de Californie et de l’institut Pasteur à Paris sur la création d’une version du moustique Anopheles (Cellia) stephensi, une espèce présente en Inde et au Moyen-Orient, capable de bloquer le développement du parasite de la malaria grâce à une modification génétique. L’espoir des chercheurs réside dans la transmission de cette caractéristique de générations en générations de moustiques. Ils ne précisent pas le délai nécessaire pour obtenir un début de réduction du nombre de cas d’infection chez l’homme.

L’équipe d’Anthony James a publié cette avancée dans la revue Proceedings of the National Academy of Sciences (PNAS) du 11 juin 2012. Elle y explique que l’avantage de sa méthode est de pouvoir être appliquée à des dizaines d’espèces différentes de moustiques qui transportent et transmettent le parasite de la malaria, le Plasmodium falciparum. Dont ceux qui sévissent en Afrique.

La souris a servi de modèle

Les chercheurs ont travaillé à partir de la souris. Celle-ci, lorsqu’elle est infectée par la forme humaine de la malaria, produit des anticorps qui tuent le parasite. Anthony James a analysé les composantes moléculaires de cette réponse du système immunitaire de la souris. Et il a conçu des gènes capables de produire les mêmes molécules chez le moustique. Les anticorps libérés par les moustiques génétiquement modifiés tuent le parasite et évite toute propagation de la maladie lors de leurs piqures sur des êtres humains. “Nous constatons une complète disparition de la version infectieuse du parasite de la malaria”, note Anthony James. D’après lui, “le processus de blocage à l’intérieur de l’insecte qui transporte la malaria peut réduire significativement le nombre de cas de cette maladie et son taux de morbidité”. Son équipe n’en est pas à sa première modification génétique d’un moustique. Elle a également travaillé sur la réduction de la transmission de la dengue et d’autres maladies du même type.

Il reste donc à évaluer l’impact de tels moustiques OGM sur des populations de milliards d’insectes. Combien faut-il en produire pour accélérer la transmission héréditaire des gènes modifiés? Quelle est la vitesse de propagation du gène? A partir de quel moment les effets sur la transmission de la maladie se feront-ils sentir? Un bel espoir qui demande à être validé sur le terrain.

Michel Alberganti

lire le billet

Derniers commentaires